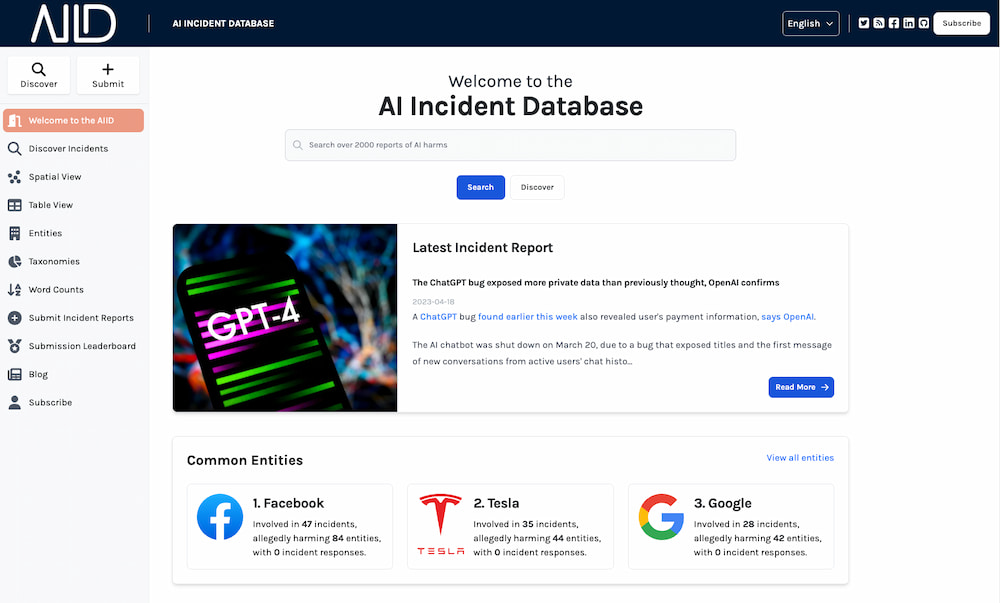

Igual que existen la base de datos de películas, de libros o de videojuegos en Internet a alguien se le ha ocurrido la feliz idea de crear la base de datos de incidentes de las inteligencias artificiales, donde se van anotando cuidadosamente las casos que saltan a las noticias. La tabla contiene una lista de sucesos del MundoReal™ que han acabado en daños (o casi) para las personas.

Este formato se parece mucho al de los incidentes de seguridad informática. La idea es que dando a conocer estos casos, que en ocasiones son bugs, fallos de concepto o problemas todavía desconocidos en las que alguien o algo la ha liao. Sabiendo más al respecto se pueden evitar malos mayores. Sobre cada incidente hay un pequeño informe que indica qué IA/empresa ha protagonizado el «problema», a qué entidad ha dañado y el tipo de prejuicio causado.

La lista de momento la encabezan:

#1 – Facebook con 46 incidentes que han dañado a 93 entidades

#2 – Tesla con 35 incidentes que han dañado a 47 entidades

#3 – Google con 28 incidentes que han dañado a 59 entidades

Los tipos de incidentes son muy variados: en el caso de Facebook hay fallos de su traductor, censura errónea, contenido «científico» generado por su IA que resultó ser dañino y sesgos en algunos de sus algoritmos. En el de Tesla son más bien fallos del sistema de conducción autónoma y otros sistemas de los vehículos, y problemas en la robótica de la fabricación de los coches y en el de Google hay desde insultos con el autocompletar al famoso incidente en que su IA confundía a las personas negras con gorilas y a anuncios racistas filtrados en Google AdSense.

La idea parece buena, aunque el trabajo va a ser ímprobo a medida que aparecen más y más IAs por todas partes. El sitio parece muy bien diseñado pero ha de actualizarse continuamente. La sección de taxonomías es especialmente interesante porque permite filtrar los datos por tipos de daños, datos demográficos, tecnologías, objetivos de las IAs y demás. Por ejemplo entre los objetivos están: conducir, filtrar palabrotas, filtrar contenidos de odio, reconocer rostros, y otros.

Se puede seguir la actualidad de los incidentes en su blog o en Twitter @IncidentsDB y otras redes sociales. Está claro que peligros hay muchos e incidentes va a haberlos también, así que no está mal mantenerse al día.

Relacionado:

OpenAI habla sobre sus planes para la inteligencia artificial general del futuro, incluyendo los riesgos que implica

Código inmoral: un documental que muestra los peligros de un mundo demasiado automatizado

El Centro para el Estudio de los Riesgos Existenciales y los diversos «fines del mundo» de la Universidad de Cambridge

Los problemas morales y sociales de utilizar la IA para hacer los deberes

La mortífera verdad sobre la Inteligencia Artificial: el experimento mental del coleccionista de sellos